| 模型 | 尺寸 (像素) |

mAPval 50-95 |

CPU ONNX 速度 (ms) |

A100 TensorRT 速度 (ms) |

参数 (M) |

FLOPs (B) |

|---|---|---|---|---|---|---|

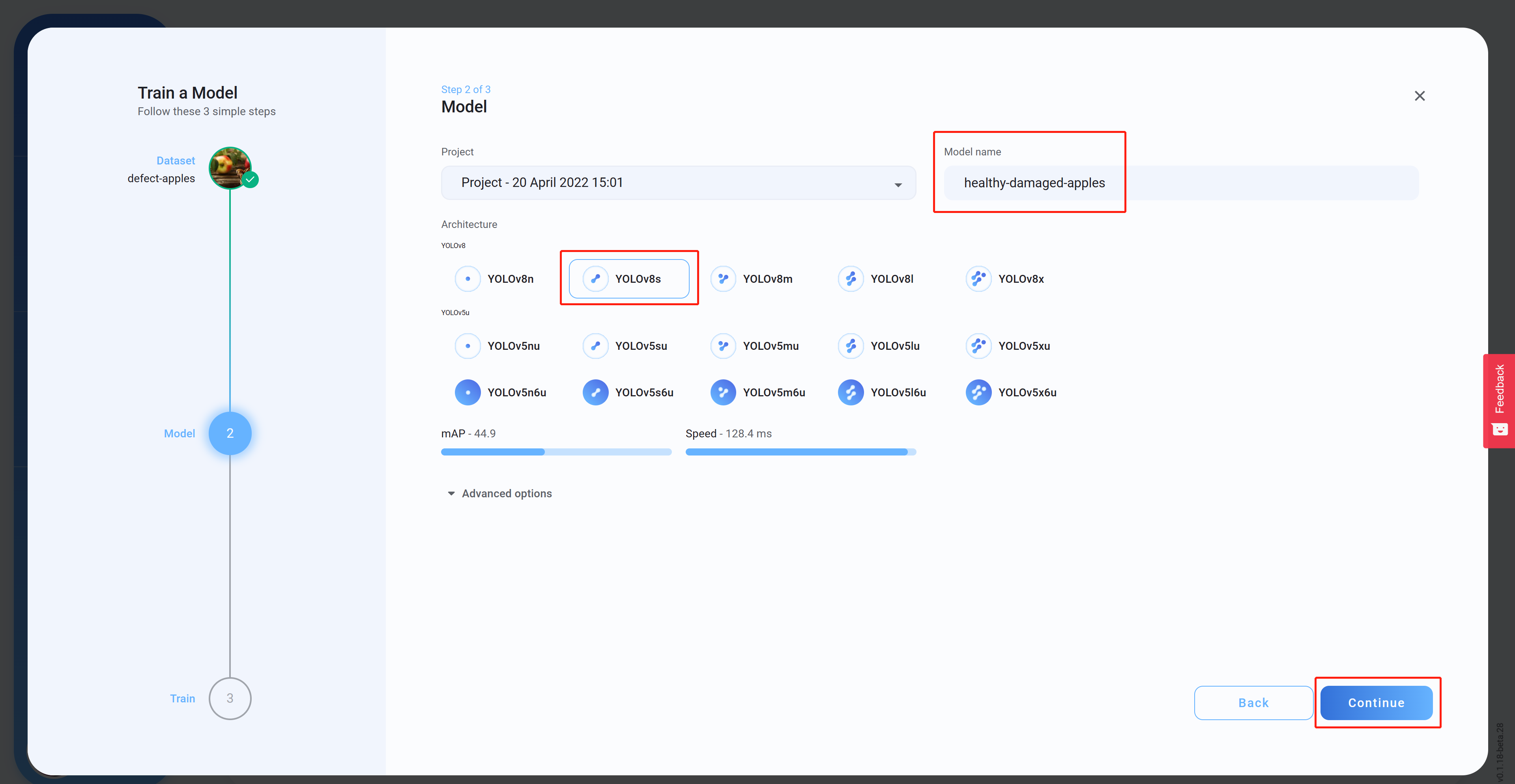

| YOLOv8n | 640 | 37.3 | 80.4 | 0.99 | 3.2 | 8.7 |

| YOLOv8s | 640 | 44.9 | 128.4 | 1.20 | 11.2 | 28.6 |

| YOLOv8m | 640 | 50.2 | 234.7 | 1.83 | 25.9 | 78.9 |

| YOLOv8l | 640 | 52.9 | 375.2 | 2.39 | 43.7 | 165.2 |

| YOLOv8x | 640 | 53.9 | 479.1 | 3.53 | 68.2 | 257.8 |

| 模型 | 尺寸 (像素) |

acc top1 |

acc top5 |

CPU ONNX 速度 (ms) |

A100 TensorRT 速度 (ms) |

参数 (M) |

FLOPs (B) at 640 |

|---|---|---|---|---|---|---|---|

| YOLOv8n-cls | 224 | 66.6 | 87.0 | 12.9 | 0.31 | 2.7 | 4.3 |

| YOLOv8s-cls | 224 | 72.3 | 91.1 | 23.4 | 0.35 | 6.4 | 13.5 |

| YOLOv8m-cls | 224 | 76.4 | 93.2 | 85.4 | 0.62 | 17.0 | 42.7 |

| YOLOv8l-cls | 224 | 78.0 | 94.1 | 163.0 | 0.87 | 37.5 | 99.7 |

| YOLOv8x-cls | 224 | 78.4 | 94.3 | 232.0 | 1.01 | 57.4 | 154.8 |

| 模型 | 尺寸 (像素) |

mAPbox 50-95 |

mAPmask 50-95 |

CPU ONNX 速度 (ms) |

A100 TensorRT 速度 (ms) |

参数 (M) |

FLOPs (B) |

|---|---|---|---|---|---|---|---|

| YOLOv8n-seg | 640 | 36.7 | 30.5 | 96.1 | 1.21 | 3.4 | 12.6 |

| YOLOv8s-seg | 640 | 44.6 | 36.8 | 155.7 | 1.47 | 11.8 | 42.6 |

| YOLOv8m-seg | 640 | 49.9 | 40.8 | 317.0 | 2.18 | 27.3 | 110.2 |

| YOLOv8l-seg | 640 | 52.3 | 42.6 | 572.4 | 2.79 | 46.0 | 220.5 |

| YOLOv8x-seg | 640 | 53.4 | 43.4 | 712.1 | 4.02 | 71.8 | 344.1 |

| 模型 | 尺寸 (像素) |

mAPpose 50-95 |

mAPpose 50 |

CPU ONNX 速度 (ms) |

A100 TensorRT 速度 (ms) |

参数 (M) |

FLOPs (B) |

|---|---|---|---|---|---|---|---|

| YOLOv8n-pose | 640 | 50.4 | 80.1 | 131.8 | 1.18 | 3.3 | 9.2 |

| YOLOv8s-pose | 640 | 60.0 | 86.2 | 233.2 | 1.42 | 11.6 | 30.2 |

| YOLOv8m-pose | 640 | 65.0 | 88.8 | 456.3 | 2.00 | 26.4 | 81.0 |

| YOLOv8l-pose | 640 | 67.6 | 90.0 | 784.5 | 2.59 | 44.4 | 168.6 |

| YOLOv8x-pose | 640 | 69.2 | 90.2 | 1607.1 | 3.73 | 69.4 | 263.2 |

| YOLOv8x-pose-p6 | 1280 | 71.6 | 91.2 | 4088.7 | 10.04 | 99.1 | 1066.4 |

| Key | Value | Description |

|---|---|---|

| imgsz | 640 | Image size as scalar or (h, w) list, i.e. (640, 480) |

| half | False | FP16 quantization |

| dynamic | False | Dynamic axes |

| simplify | False | Simplify model |

| workspace | 4 | Workspace size (GB) |